♥ Partecipa anche tu alle donazioni: sostieni SaggiaMente, sostieni le tue passioni!

Gli smartphone non potranno mai essere tecnicamente al pari delle fotocamere, almeno non dal punto di vista hardware. Non esiste la possibilità fisica che un sensore minuscolo con sopra una lente più piccola di una lenticchia possa generare gli stessi risultati di una reflex / mirrorless. E non parlo solo delle full-frame ma anche delle APS-C e Micro Quattro Terzi. Per questo motivo sono ormai anni che nel settore mobile si spinge sul software, nel tentativo di colmare il gap tramite machine learning, reti neurali, intelligenza artificiale e tutte quelle altre belle parole che ormai non mancano in nessun comunicato stampa. Da quando questi strumenti vengono applicati massicciamente nell’imaging è nato il concetto di Fotografia Computazionale, ovvero quella in cui lo strato hardware viene massicciamente coadiuvato da quello software per superare i propri limiti.

la Fotografia Computazione usa il software per superare i limiti hardware degli smartphone

Sono molti anni che se ne fa uso ed è il motivo per cui è effettivamente più facile ottenere un’immagine “buona” con uno smartphone che non con una vera fotocamera. Su entrambe premiamo un pulsante, ma quando lo facciamo su uno smartphone avvengono molte altre cose a nostra insaputa. La più banale è quella di effettuare diverse esposizioni scegliendo automaticamente quella migliore, ad esempio con i soggetti non mossi, ma negli ultimi tempi le capacità di calcolo dei dispositivi mobili sono così aumentate da offrirci nuove possibilità.

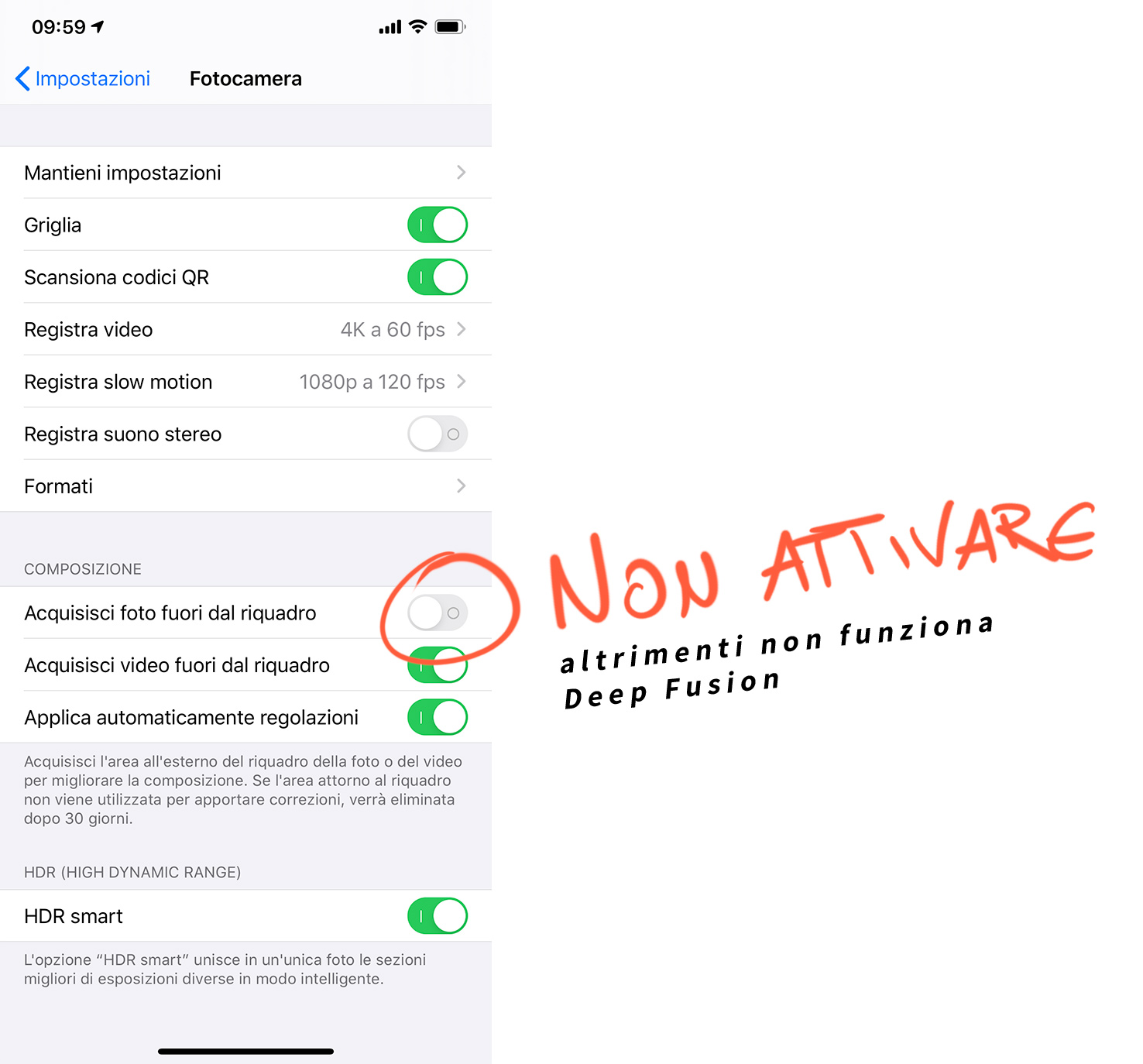

Con gli iPhone 11 anche Apple si è data da fare, introducendo funzionalità come lo Smart HDR, la Night Mode ed ora anche Deep Fusion. Quest’ultima è ancora presente solo nella versione Beta di iOS 13.2, ma sarà presto resa disponibile a tutti quanti. La sto provando da qualche giorno e devo dire che l’implementazione è fin troppo nascosta agli occhi degli utenti. Non c’è un segnale che indica quando entra in funzione e non si può attivare manualmente. Anzi, se per caso si attiva nelle Impostazioni / Fotocamera l’opzione “Acquisisci foto fuori dal riquadro” Deep Fusion non funzionerà e non vi è alcuna avvertenza. L’approccio iper-semplificativo di Apple continua a non andarmi giù, ma c’è un motivo per cui questo avviene ed è che non si possono fare entrambe le cose contemporaneamente.

Deep Fusion agisce principalmente in condizioni di luce non ottimale e solo quando non entrano in gioco altre modalità, come lo Smart HDR (tipicamente attivo con forte luce) e Night Mode (che al contrario si attiva con poca luce). Il funzionamento richiede la realizzazione di diverse foto, alcune precedenti ed altre successive alla nostra pressione del pulsante di scatto. A queste si aggiunge anche un’immagine sotto esposta per avere tempi di scatto più veloci, e dunque evitare il mosso per dettagli più nitidi, ed un’altra con esposizione più lunga per recuperare al meglio i colori e le aree buie. Il tutto viene poi miscelato dal processore e dalla NPU (Neural Processing Unit) per avere una singola foto con più dettagli e minor rumore.

Il motivo per cui ciò non avviene attivando l’acquisizione foto fuori quadro è che quell’impostazione richiede un’operazione diversa e non cumulabile con la precedente. In quel caso l’iPhone dovrà infatti scattare contestualmente anche l’immagine con la fotocamera più grandangolare (quindi non funziona sulla ultra-wide) per darci la possibilità di recuperare in futuro le parti esterne che sono state tagliate dall’inquadratura per errore.

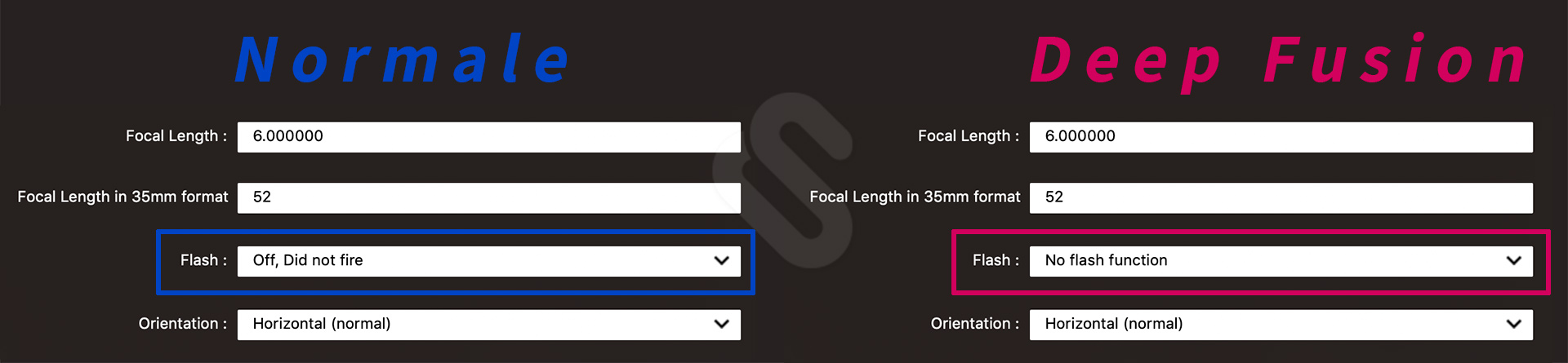

Deep Fusion funziona anche su iPhone 11 non Pro, ma dal momento che si attiva solo nelle condizioni sopra descritte, succederà molto più spesso di vederlo attivo sui modelli Pro utilizzando il “tele” che è leggermente più buio e richiede tempi di scatto più veloci (cosa che riduce ancora la luminosità catturabile). Provando a controllare i dati EXIF non c’è una chiara evidenza del fatto che sia risultato attivo in una foto, ma si può capire per vie traverse. Nella modalità Deep Fusion non è infatti disponibile il flash, dunque pur non utilizzandolo vedremo un’indicazione differente rispetto alle altre foto:

- Deep Fusion senza flash: “No flash function”

- Foto Normale senza flash: “Off, Did not fire”

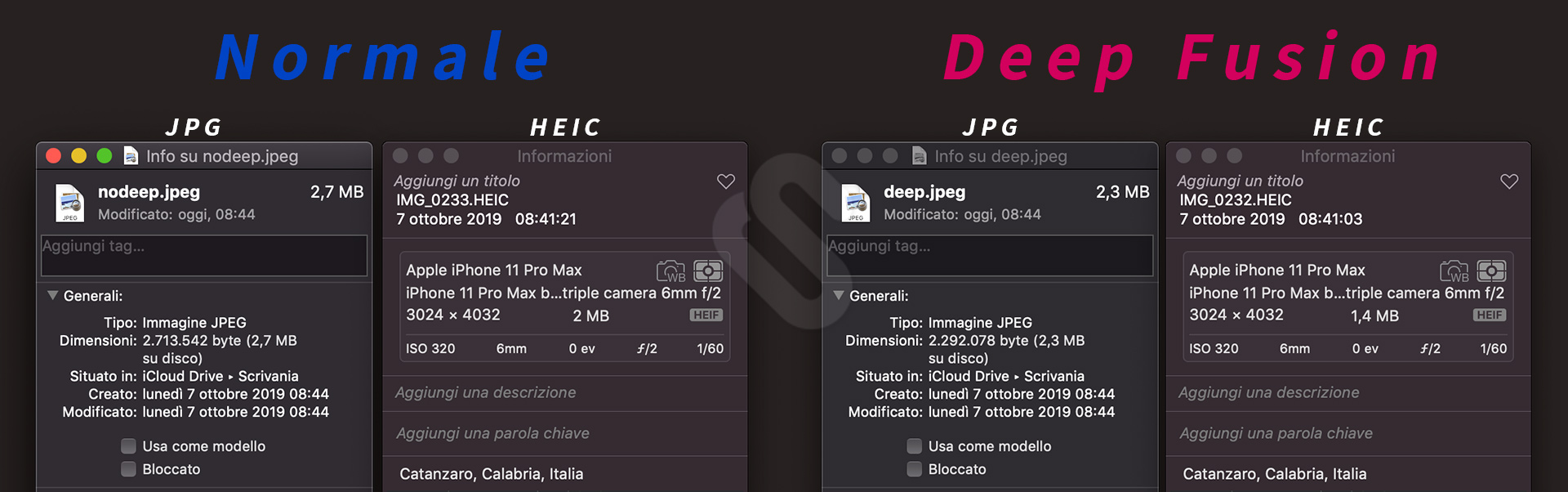

Ora, considerando tutto il lavoro per catturare più immagini e il fatto che quella definitiva abbia effettivamente molto più dettaglio, si potrebbe giustamente supporre che la foto catturata con Deep Fusion pesi di più, ma in realtà è il contrario. Ho fatto numerose prove in tal senso perché mi sembrava davvero strano, ma in tutti i casi l’immagine normale pesava circa il 20% in più. E questo sia scattando in HEIC (alta efficienza) che in JPG.

A mio avviso questo apparente paradosso ha a che fare con due caratteristiche delle foto Deep Fusion:

- la prima è che c’è meno rumore sottile e questo è un elemento piuttosto difficile da comprimere dato che risulta caratterizzato da tanti pixel di diversa luminosità e colore anche su una superficie che in teoria è tutta uniforme;

- la seconda è che rispetto alle foto normali Apple utilizza attualmente un fattore di compressione superiore, cosa che si nota per la presenza di maggiori artefatti a fronte di una migliore qualità complessiva in termini di dettaglio.

Entrambe le mie affermazioni si poggiano sui test che ho realizzato e potete verificarle voi stessi tramite i crop qui sopra. È evidente che la fotografia con Deep Fusion abbia molta più incisività ed informazioni, ma se notate intorno alla P di iPod e in tante altre parti di contorno, i tipici blocchi della compressione lossy sono più visibili rispetto alla foto normale. Essendo ancora una funzione in beta, però, è possibile che Apple apporti degli affinamenti in corso d’opera: dopotutto non c’è necessità o motivo che una foto con maggiori dettagli sia più leggera e compressa. Nel frattempo potete scaricare queste due immagini di prova qui:

- Foto Normale https://res.saggiamente.com/s/nodeep.jpeg

- Deep Fusion https://res.saggiamente.com/s/deep.jpeg

Articoli correlati

Nessun articolo.