♥ Partecipa anche tu alle donazioni: sostieni SaggiaMente, sostieni le tue passioni!

Apple ha pubblicato questa mattina un documento in cui illustra delle nuove misure per la protezione dei minori nei propri dispositivi. La questione non mancherà di far discutere poiché il fine è universalmente condivisibile, ma i mezzi possono non esserlo.

Iniziamo col dire che il tutto funzionerà solo negli Stati Uniti al momento del lancio e richiederà le nuove versioni dei sistemi operativi: iOS 15, iPadOS 15 e macOS Monterey. Tuttavia sarà esteso anche nelle altre regioni nel corso del tempo, quindi è bene iniziare a capire di cosa si tratta.

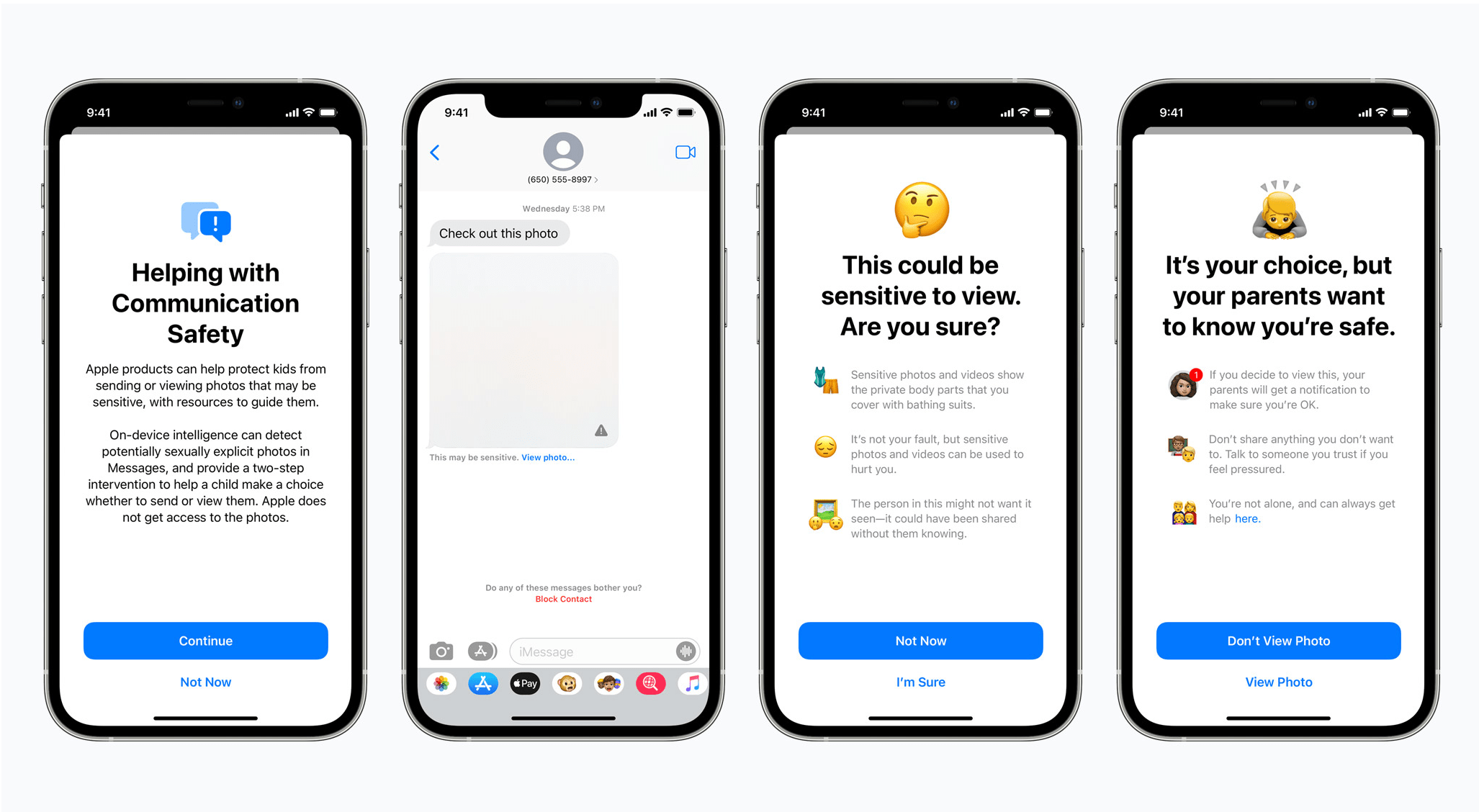

La prima misura è stata definita communication safety e si occupa di individuare fotografie con contenuto sessuale esplicito scambiate tramite iMessage nei dispositivi usati da minori. L’analisi sarà completamente in locale e verrà mantenuta la crittografia end-to-end, quindi il contenuto non sarà visualizzato da Apple o chi per lei, semplicemente oscurato con una sfocatura inviando una notifica ai genitori.

Fatte le dovute precisazioni, questo primo punto sembra piuttosto semplice da capire e neanche troppo controverso, seppure non mi è chiaro se sarà una funzione opzionale dell’area di controlli parentali oppure se sarà imposta a tutti. Ritengo dovrebbe trattarsi di una opzione ma, in qualità di genitore, penso che l’attiverei comunque… questo detto completamente senza veli e senza soffermarmi troppo a ragionare sulle implicazioni morali e sociali. Posto che tanto si tratterebbe di una limitazione velleitaria nel mare di Internet e delle comunicazioni, vedo più importare un’azione volta a limitare potenziali minacce in contatto diretto con i minori che non magari un sito con contenuti pornografici. Ma questa è solo una mia opinione, ci mancherebbe.

La seconda misura è decisamente più complessa, sia nel funzionamento che per le possibili ricadute. Parliamo di CSAM che si occuperà di identificare su iCloud Foto eventuali immagini già note relative ad abusi su minori. Per essere note vuol dire che c’è un database – ovvero quello del National Center for Missing and Exploited Children (almeno finché si ragionerà solo con gli U.S.) – e per essere identificate bisognerà analizzare le nostre foto – quindi addio privacy. Chiaramente non poteva essere così, cioè Apple non poteva prendersi la libertà di analizzare le nostre immagini, quindi ha pensato ad una soluzione diversa.

Detto molto semplicemente (vi invito a leggere il documento per approfondire) la tecnologia NeuralHash trasforma le immagini in quel database in un hash, ovvero un numero univoco, e la stessa cosa viene fatta in locale per le nostre immagini prima di mandarle su iCloud Foto. Quindi, l’unica informazione che viaggerà tra il nostro dispositivo e i server remoti sarà un hash da confrontare con gli altri presenti nel database.

La questione diventa più intricata nel momento in cui c’è una corrispondenza, in quanto l’immagine viene comunque inviata su iCloud Foto insieme ad un “cryptographic safety voucher” e quando il numero di questi supera una certa soglia (purtroppo non dichiarata) allora qualcuno ad Apple sarà avvisato e sarà effettuata una verifica manuale con possibili ripercussioni, come la disabilitazione dell’account e l’invio di un report alla già citata NCMEC.

Apple assicura che il sistema è molto affidabile e che è capace di riconoscere le immagini anche se sono tagliate o modificate nei colori. Certo, si tratta di agire su materiale che noi tutti vorremmo non esistesse (ovvero fotografie derivanti da abusi su minori) ed è apprezzabile lo sforzo per tutelare la privacy analizzando in locale e confrontando solo gli hash, ma ci si sta muovendo sul filo del rasoio. A differenza della misura relativa ad iMessage, qui Apple si prende anche il diritto, nonché l’onere e la responsabilità, di analizzare il tutto in prima persona in caso di numerosi esiti positivi (e senza dichiarare la soglia esatta). Per cui, volenti o nolenti, ci mette nella posizione di doverci fidare del suo “software” e sappiamo che questo è fallibile per definizione. Per questo, anche senza scivolare nei facili allarmismi, questo CSAM farà e deve far discutere.

Infine, sia Siri che Spotlight saranno istruiti al fine di fornire ulteriori informazioni sul sistema di protezione e sulle misure in atto.

Articoli correlati

Nessun articolo.